时序信息运用篇

-

前景提要:智慧交通项目上,因为第三张图的车开得比较远,车的重识别效果不好,所以考虑能否将时序信息用上,就关注了一些这方面的工作。

《Temporal-Context Enhanced Detection of Heavily Occluded Pedestrians》 ————CVPR 2020

原文链接: https://cse.buffalo.edu/~jsyuan/papers/2020/TFAN.pdf

行人检测作为计算机视觉领域最基本的主题之一,多年来被广泛研究。尽管最先进的行人检测器已在无遮挡行人上取得了超过 90% 的准确率,但在严重遮挡行人检测上依然无法达到满意的效果。究其根源,主要存在以下两个难点:

- 严重遮挡的行人框大部分为背景,检测器难以将其与背景类别区分;

- 给定一个遮挡行人框,检测器无法得到可见区域的信息;

针对这两大难题,地平线与 Buffalo 学院提出 Tube Feature Aggregation Network(TFAN)新方法,即利用时序信息来辅助当前帧的遮挡行人检测,目前该方法已在 Caltech 和 NightOwls 两个数据集取得了业界领先的准确率。

主要步骤。(i)Tube linking:从当前框架中的行人方案出发,在相邻框架中迭代搜索相关的对等物(不一定是同一个人),从而形成tube;(ii)特征聚合:将成型tube中的建议特征进行聚合,根据其与当前候选建议的语义相似性进行加权,增强当前帧中行人的特征表示。

Proposal tube 解决严重遮挡行人检测

如下图,给定一个视频序列,首先对每帧图像提取特征并使用 RPN(Region Proposal Network)网络生成 proposal 框。 从当前帧的某个 proposal 框出发,依次在相邻帧的空间邻域内寻找最相似的proposal框并连接成 proposal tube。

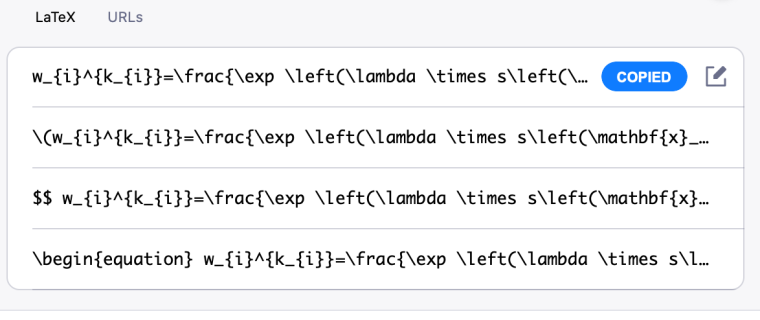

在相邻的第 i 帧和第 i-1 帧之间,具体两个 proposal 的匹配准则可根据以下公式:

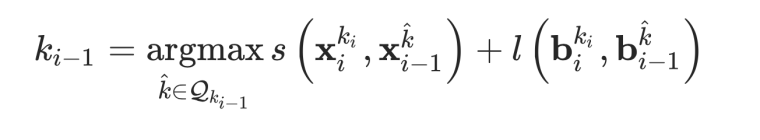

其中 s 是用于计算两个 proposal 特征的余弦相似度,而 l 是用于计算两个 proposal 在尺寸大小及空间位置上的相似程度(具体公式如下)。X 和 b 分别表示 proposal 特征和 proposal 边界框,字母的上标表示 proposal 编号,表示在第 i-1 帧搜索区域内的 proposal 框的编号集合。

(scale使两个proposal长宽比相似,location使空间位置相似,d为建议的中心与回归目标的offset)

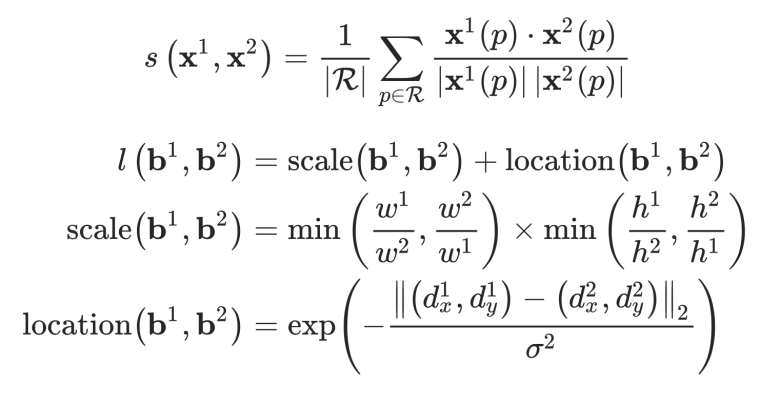

假设视频序列共有 13 帧,可以得到一个具有 13 个 proposal 框的 tube 以及他们对应的 proposal 特征。这样的做法可以有效的将时序上前后存在的无遮挡行人连接到 proposal tube 当中。随后,将这些 proposal 特征以加权求和的方式融合到当前帧的 proposal 特征中来,具体的融合权重可根据以下公式求得:

其中,τ 代表时序上前后各有 τ 帧,λ 为常数,t 表示当前帧。此做法可以避免无关的特征被错误融合进来。当背景框被连接到了行人的 tube 当中,他们的特征相似度较低,所以最后产生的融合权重较小,从而防止了行人特征被背景特征所污染,反之亦然。最后,我们将融合后的特征送入分类器,从而更好的识别严重遮挡的行人。

TDEM模块(Temporally Discriminative Embedding Module)有效避免行人框与背景框交叉

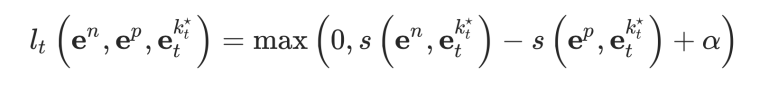

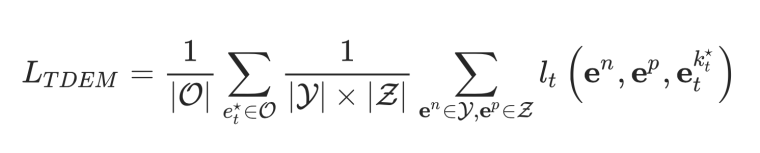

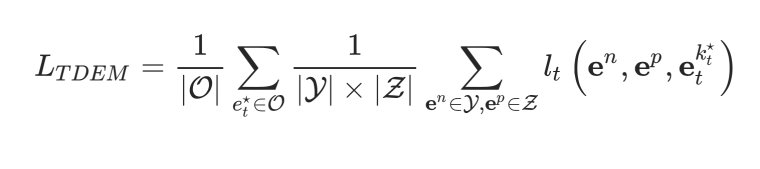

为了避免连接 tube 过程中发生错误的偏移,比如行人框连到了背景框,或背景框连到了行人框。针对这种情况,研究团队提出 TDEM(Temporally Discriminative Embedding Module)模块用于将原 proposal 特征映射到一个 embedding 空间,然后利用 embedding 特征来计算两个 proposal 之间的特征相似度。在这个 embedding 空间我们可利用损失函数来进行监督,使行人的 embedding 与前后帧背景的 embedding 相互排斥与前后帧行人的embedding相互吸引。具体的损失函数由 triplet loss 实现如下:

其中, , 分别代表前后帧背景,行人和当前帧行人的 embedding 特征。

利用 PRM(Part-based Relation Module)模块解决融合权重较少的问题

在 PRM 模块中,首先预测当前帧行人的可见区域位置。然后,在比较两个行人框特征的相似度时,只会计算在这个可见区域内的相似度。如下图(a)右,当只比较两个行人的上半身相似度时,我们会发现他们其实是同一个人,由此产生的融合权重会较高。

计算公式:

下图显示了 PRM 的可视化结果,我们发现 PRM 模块计算的相似度会比直接使用全身特征计算的相似度更高。

Implementation

1.Training:

这里要注意的是,因为数据并没有提供track-id,作者采用前后帧中的bbox与当前帧中的bbox计算IoU,将其最大的IoU取出,并将IoU作为matching score。

2.Inference:

将行人检测的任务,分成回归与分类的两个部分,在分类时使用本文的增强特征。

团队的latex什么时候能改进一下,要是能支持Mathpix四个中的一种就好了